Postępy jakie dokonywały się od czasu XVII wiecznej rewolucji naukowej doprowadziły w XX wieku do powstania technologi informacyjnej, jaką znamy teraz.

Pierwsze komputery

Wyznaczenie jednego momentu, który można by uznać za początek powstawania komputerów jest, jak to zwykle bywa z takimi próbami, niemożliwe. Matematyka dzięki której istnieją komputery liczy sobie tysiące lat i jest prawdopodobnie starsza od pisma. Sam koncept myślącej maszyny pojawiał się już w starożytności i zaczął szybko zyskiwać na popularności od czasów oświecenia. Być może za pierwszy komputer można by uznać urządzenie z Antykithery, które powstało około stulecia przed naszą erą i potrafiło przewidywać ruchy słońca, księżyca oraz planet po gwiazdozbiorach zodiaku oraz podawać daty zaćmień słońca i księżyca. Część badaczy uważa, że taki pogląd jest uzasadniony.

Wraz z szybkimi postępami w matematyce i technice, jakie miały miejsce w XIX wieku, w okolicach II Wojny Światowej stało się możliwe stworzenie pionierskich komputerów. Jednym z pierwszych był Z-3 zbudowany w Berlinie przez Konrada Zuse. Był on w stanie dokonywać obliczeń aerodynamicznych, które pomagały Berlińskiemu Instytutowi Badań nad Lotnictwem prowadzić badania nad konstrukcją samolotów. Pierwsze wersje komputera, nazwane Z-1 i Z-2 nie były sprawne i wyłączały się po paru minutach. Niestety, Z-3 ulega zniszczeniu podczas bombardowania Berlina.

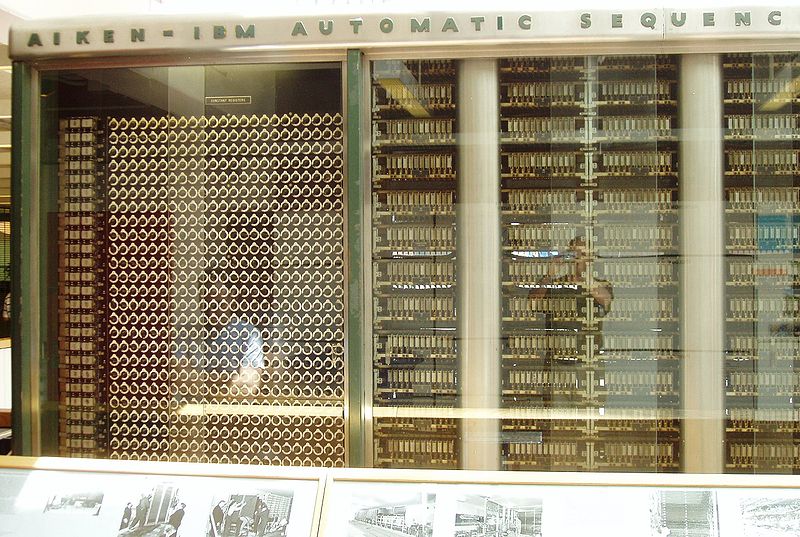

Niedługo potem w Harvardzie powstaje Mark 1. Był on wykorzystywany podczas projektu Manhattan w celu badania implozji broni atomowej. W 1948 roku powstaje pierwszy program komputerowy, którego twórcami byli Frederic Williams, Tom Kilburn i Geoff Toothkill. Program służył do testowania nowych sposobów zapisu pamięci.

W latach pięćdziesiątych nastąpił gwałtowny rozwój komputerów. Zajmowały one co prawda cały pokój, a zamiast dysków twardych zapisywały dane na taśmach z dziurkami, ale za to działały coraz sprawniej i były użyteczne dla naukowców, którzy z nich korzystali.

W 1951 roku powstaje Ferranti Mark 1, który był pierwszym komercyjnie dostępnym komputerem. Zostało sprzedanych dziewięć sztuk tego urządzenia. W 1954 roku IBM tworzy IBM 650, który staje się pierwszym komputerem wyprodukowanym na masową skalę. W przeciągu roku 450 sztuk maszyny trafia do uniwersytetów, na których pierwsze pokolenie programistów uczy się swojego rzemiosła. Dwa lata później powstaje najwcześniejsza klawiatura, która znacznie ułatwia wpisywanie komend do komputera.

TX-0 jest pierwszym komputerem, który został wybudowany korzystając z technologi tranzystorów. Na przełomie lat 50-tych i 60-tych powstaje sieć SAGE. Łączyła ona 23 komputery, które wspólnie monitorowały niebo w poszukiwaniu atakujących sowieckich samolotów. SAGE była najstarszym przodkiem współczesnego Internetu. Oto fragment ówczesnego programu telewizyjnego wyjaśniającego działanie sieci:

Powstanie Internetu

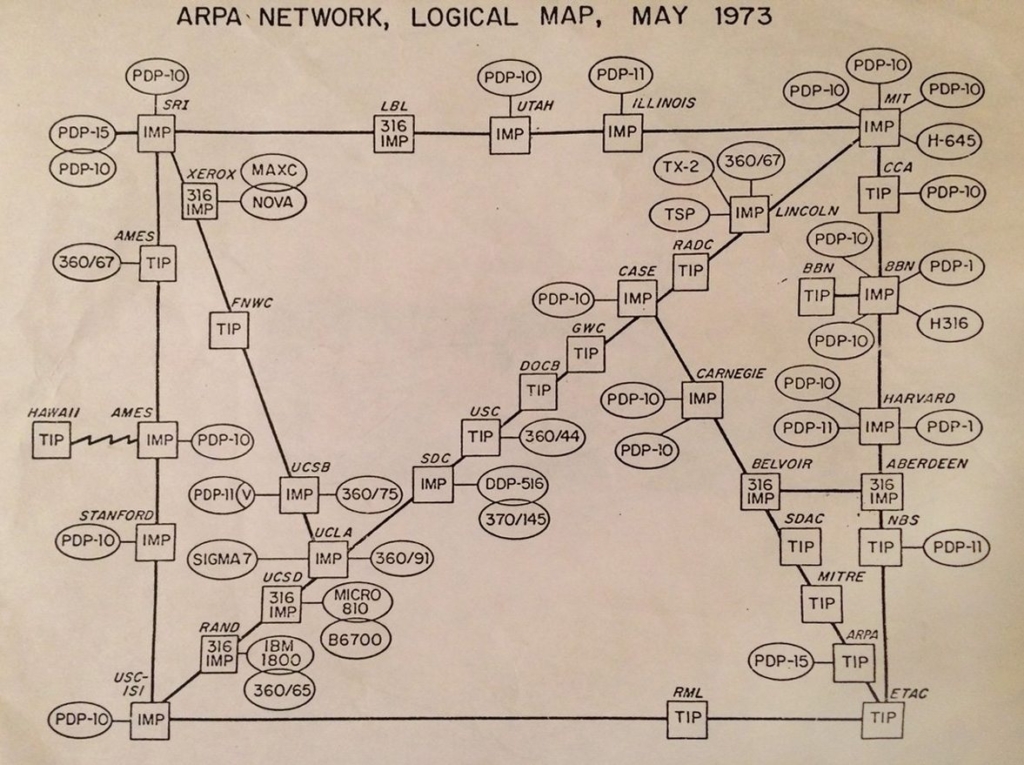

Pod koniec lat 60-tych nastąpił kolejny przełom w rozwoju technologii IT. Pentagon ufundował sieć ARPANET, która była prekursorem dzisiejszego Internetu. Jej początki były skromne, ARPANET miał za zadanie połączyć kilka ośrodków badawczych za pomocą linii telefonicznej w celu zapewnienia lepszej komunikacji między nimi. Z czasem coraz więcej instytucji zaczęło dołączać się do sieci.

Poza funkcjami naukowymi ARPANET istniał i był rozbudowany także z powodu ambicji wojskowych marzących o systemie komunikacji, który nie posiadałby centrali. W razie wybuchu wojny nuklearnej niemożliwe byłoby zniszczenie komunikacji wojskowej ponieważ żaden węzeł sieci nie byłby ważniejszy od innych i nie dałoby się jej wyłączyć poprzez zniszczenie jej kluczowych odcinków.

Badawczo-wojskowa sieć przesyłała dane w sposób dosyć prosty. Informacja dzielona była na mniejsze pakiety, które wysyłane były z jednego komputera do drugiego. Poszczególne pakiety wędrowały rożnymi drogami do swojego docelowego miejsca. Kiedy tam dotarły, łączone były z powrotem w jedną, kompletną informację, która była identyczna jak ta, która wyszła z komputera, z którego ją wysłano.

W tych czasach około 70% badań związanych z IT było fundowane przez ARPA, ale nie wszystkie postępy jakie odbyły się wtedy służyły tylko i wyłącznie celom militarnym. Nastąpił rozwój grafiki komputerowej, obliczeń równoległych i wielu innych fundamentalnych technologii jakie znamy dzisiaj.

Kiedy sieć zaczęła się rozszerzać, zdano sobie sprawę, że doczepianie do niej kolejnych komputerów jest zbyt trudne. Dlatego też, w latach 70-tych wynaleziony zostaje protokół IP, który używany jest do dziś.

W latach 80-tych, wraz z powstawaniem Internetu w innych niż Stany krajach, ARPANET zostaje podzielony na dwie osobne sieci: militarną oraz cywilną. Powstaje fraza „Internet”, która pochodzi od zwrotu „inter-network”, który powstał po to, aby przekazać ideę głoszącą, że obie rodzaje sieci są ze sobą połączone i tworzą jedną całość. ARPANET zostaje wyłączony i zastępują go sieć działająca wyłącznie w oparciu o protokół IP.

W 1992 roku Tim Berners-Lee tworzy World Wide Web. WWW pozwala na łączenie stron internetowych za pomocą linków co w sposób znaczący ułatwia przeglądanie sieci. Dzięki tej technologii pierwsze przeglądarki takie jak Mosaic stają się wygodne w użytkowaniu, co pozwala na szybki rozwój sieci jaki następuje w latach 90-tych. Podczas tej dekady korzystanie z Internetu staje się czymś powszechnym i ludzkość wchodzi w XXI wiek będąc już oswojona z technologią, która zdefiniuje te stulecie, albo przynajmniej jego początki.

Dalszy rozwój komputerów

W 1964 roku powstaje komputer Atlas. Jako pierwszy wykorzystywał on pamięć wirtualną co znacznie zwiększyło jego siłę obliczeniową, poza tym działał na nim program Atlas Supervisor, który czasem uznawany jest za najstarszy system operacyjny.

W tym samym czasie oddany do użytku zostaje CDC 6600, który wydaje się być pierwszym super komputerem na świecie. CDC 6000 wykorzystywał kilka mniejszych komputerów, które biorąc na swoje barki znaczną część obliczeń odciążały główny procesor.

Rok później powstaje DDP-116. Jest on pierwszym komercyjnie dostępnym komputerem korzystającym z 16 bitowego procesora. Sprzedał się w 172 egzemplarzach, z których każdy kosztował niemalże 30 tysięcy dolarów. Niedługo potem powstaje tańszy komputer PDP-8, który kosztował 18 tysięcy dolarów i sprzedał się już w kilku tysiącach sztuk.

W 1964 roku współpraca IBM i American Airlines doprowadza do powstania skomputeryzowanego systemu rezerwacji biletów lotniczych dumnie nazwanego „SABRE”. Wcześniej rezerwacje przetwarzane były ręcznie, co średnio zajmowało półtorej godziny na jednego podróżnego. System pozwolił na skrócenie tego czasu do kilku sekund i potrafił obsłużyć 7,5 tysięcy rezerwacji na godzinę.

W całej tej historii najciekawsze jest to, że współpraca doszła do skutku tylko dlatego, że młody pracownik działu sprzedaży IBM Blair Smith przypadkowo podczas swojej podroży samolotem trafił na miejsce obok którego siedział prezes American Airlines. Panowie rozmawiali że sobą. Prezesa zafascynowała możliwość wykorzystania nowej technologii do usprawnienia procesu rezerwacji i dał Blairowi swój numer telefonu prosząc go o kontakt.

W 1968 roku powstaje Apollo Guidance Computer, który wykorzystany był podczas pierwszego lądowania człowieka na księżycu. Sukcesem była w tym przypadku miniaturyzacja urządzenia. Udało się zmniejszyć rozmiar komputera, który wcześniej zajmował powierzchnię siedmiu lodówek, do kostki o wielkości 30 cm kwadratowych. Często mówi się, że komputer, który zabrał człowieka na księżyc był słabszy od współczesnych komórek, które nosimy w kieszeni. Jednak mimo tej, wydawałoby się z naszej perspektywy, słabej mocy obliczeniowej, ówczesne komputery byłyby wystarczająco sprawne, żeby umożliwić wykonywanie operacji, które wcześniej były tylko marzeniem.

W tym samym roku, w którym Armstrong i Aldrin chodzili po powierzchni księżyca, na rynku ukazuje się Nova Minicomputer. Był to kolejny komercyjny komputer, tylko że tym razem jego cena została zbita do 8 tysięcy dolarów. Komercyjne pecety w tym czasie były wykorzystywane tylko przez przedsiębiorstwa, ale w 1971 roku powstaje pierwszy komputer przeznaczony do personalnego użytku: Kenbak-1. Kosztował 750 dolarów, sprzedał się w 40 egzemplarzach i doprowadził do bankructwa firmy, która go produkowała.

Rok później powstaje z kolei kalkulator HP-35, który częściowo korzystał z ówczesnych technologii komputerowych. Oferował on znacznie więcej możliwości niż inne kalkulatory sprzedawane w tym okresie i potrafił wykonać większość obliczeń jakie potrafiły w tym czasie wykonywać komputery naukowców. HP-35 okazał się być dużym sukcesem.

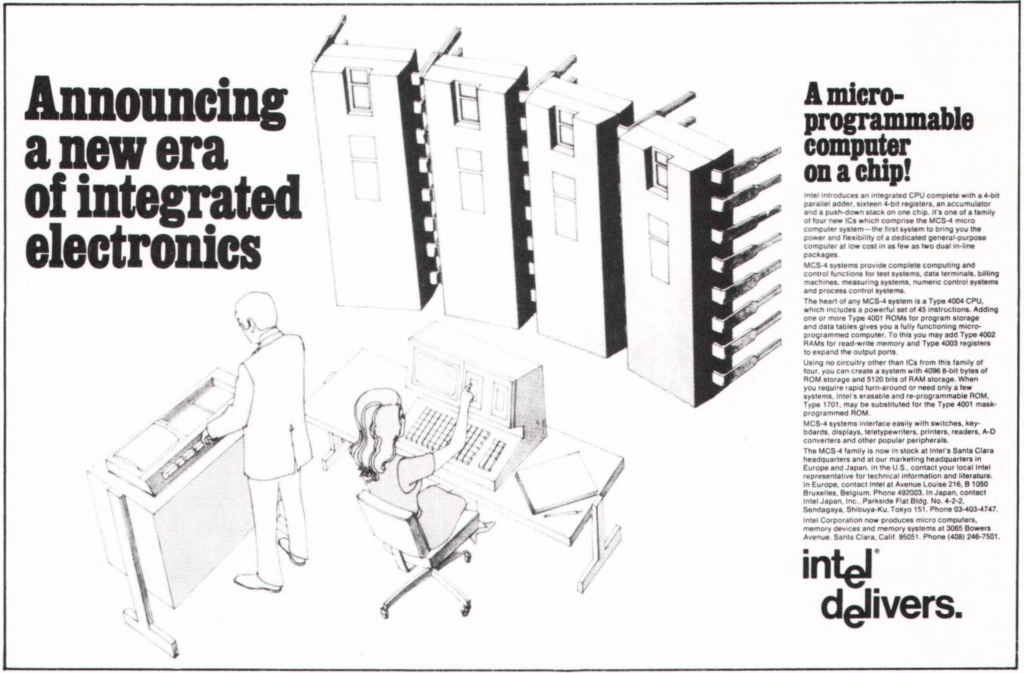

W 1971 roku następuje prawdziwy przełom. Powstaje pierwszy procesor: Intel 4004. Od tego dnia budowa komputerów zmieni się na zawsze. Porzucona zostanie architektura tranzystorowa na rzecz mikroprocesorów. Dwa lata później powstaje pierwszy komputer osobisty korzystający z procesora Intela:Micral. Kosztował on 1750 dolarów. Sprzedał się na tyle dobrze, że powstały kolejne modele tego komputera.

W roku 1975 Motorola tworzy procesor MOS 6502. Kosztował on zaledwie 25 dolarów, w co nie mogła uwierzyć ówczesna prasa podejrzewająca firmę o oszustwo. Szwedzka firma jednak wcale nie kłamała podczas swojej prezentacji. Procesor MOS 6502 pomógł znacząco zbić ceny komputerów.

Rok później powstaje Video Display Module. Dzięki niemu możliwe stało się wyświetlanie skomplikowanych grafik na ekranie komputera. Technologia tej zawdzięczamy możliwość oglądania filmów i grania w gry na naszych pecetach.

Pierwszy komputer firmy Apple trafia do sklepów w 1976 roku. Staje się on dużym sukcesem i Steve Jobs natychmiastowo postanawia stworzyć jego następcę. W tym samym roku, w którym do kin zawitały Gwiezdne wojny, na rynek wchodzi Apple II. Komputer można było podłączyć do telewizji, dzięki czemu grafika wyglądała fenomenalnie jak na tamte czasy. Apple II sprzedał się w paru milionach egzemplarzy. Model stał się jednym z najpopularniejszych komputerów na przestrzeni lat 80-tych. Produkowany był aż do 1993 roku. Wiele szkół w Stanach otrzymało Apple II za darmo, sprawiając że maszyna ta była pierwszym komputerem całego pokolenia ludzi, którzy w przyszłości zwiążą się z IT. Oto film reklamujący Apple II:

https://www.youtube.com/watch?v=6gtjbi3-oE8

W 1978 roku powstaje Altair 8800. Był on własnoręcznie składanym modelem komputera, co pozwoliło na zredukowanie kosztów jego zakupu do 300 dolarów. Jego twórca Ed Roberts jest autorem zwrotu „komputer osobisty.” Altair korzystał z procesora Intela.

Lata 80-te, czasy Commodore i Atari

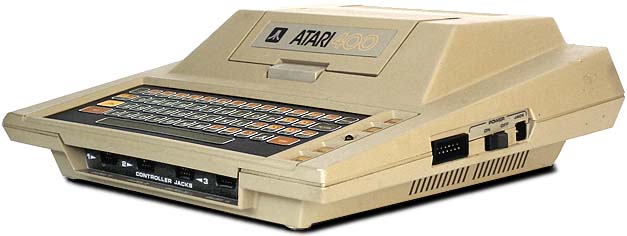

W tym samym okresie na rynek trafiają komputery od Atari. Model 400 przeznaczony był głównie do grania, a model 800 wykorzystywany był jako wszechstronny komputer domowy. Oba pecety okazały się być bardzo popularne, korzystali z nich pasjonaci żyjący w latach 80-tych.

Motorola była w tym okresie nie tylko dobra w zbijaniu cen procesorów, ale także w produkowaniu jednostek szybszych niż te należące do konkurencji. Dobrym przykładem tego jest powstały w tym czasie model Motorola 68000.

W 1980 roku premierę ma komputer Commodore VIC-20. Odnosi on olbrzymi sukces i staje się pierwszym komputerem, który zostaje sprzedany w liczbie większej niż milion egzemplarzy. Cena peceta w dniu premiery wynosiła 300 dolarów. VIC-20 był mocno promowany w środowisku nerdów, w kampanię marketingową zaangażowany został Williama Shatner. Oto spot, w którym występuje aktor znany ze Star Treka:

Popularność jaką zdobył Commodore doprowadziła do trwającej przez dużą część lat 80-tych batalii pomiędzy nim, a Atari.

W tym samym czasie, na antenie BBC pojawia się program Computer Programme, który edukował swoich widzów w zakresie tego jak działa komputer. Mogli oni, oglądając program, na żywo kopiować działania prowadzącego na swoich domowych pecetach. Wysiłki BBC zwiększyły świadomość i wiedzę na temat nowych technologii w Brytanii.

IBM wchodzi do gry o rynek domowych komputerów w 1981 roku. Korzystając z rozpoznawalności marki, komputer osobisty IBM PC sprzedaje się dobrze. Model ten korzysta z systemu MS-DOS opracowanego przez Microsoft.

1982 rok, to data wejścia na rynek Commodore 64. Ten, najlepiej chyba znany komputer z lat 80-tych, sprzedał się w liczbie 22 milionów egzemplarzy, stając się najlepiej sprzedającym się modelem komputera w historii. C64 produkowany był aż do 1993 roku. Napisano niezliczoną ilość programów na nim działających.

W tym samym czasie mamy pierwszą poważną batalię sądową w świecie komputerów. Firma Franklin skopiowała architekturę Apple II i zaczęła sprzedawać klona tego komputera za niższą cenę niż ta oferowana przez firmę Jobsa. Początkowo sąd oddalił pozew o naruszenie dóbr intelektualnych, ale w 1988 roku, Apple wygrywa walkę i Franklin otrzymuje zakaz produkcji klonów popularnego komputera.

W 1984 roku wchodzi na rynek Macintosh, który był pierwszym komputerem korzystającym z myszki oraz graficznego interface’u. Komputer był bardzo drogi, kosztował 2,5 tysiąca dolarów. Ciekawa była reklama promująca Macintosha, ponieważ przedstawiała ona firmę jako buntowniczkę walczącą z kultem Wielkiego Brata:

W 1985 roku powstaje pierwsza wersja systemu Windows. Kładzie ona niespotykany wcześniej nacisk na korzystanie z myszki, co sprawia, że nie przypada ona do gustu ówczesnych użytkowników komputerów.

W 1986 roku Amiga wprowadza na rynek swój komputer, Amigę 1000. Natychmiastowo zyskuje ona swoje grono zwolenników, ponieważ jej budowa pozwalała na szybką i prostą wymianę komponentów, dzięki czemu komputer mógł służyć dłużej bez stawania się archaicznym.

W tym czasie Intel popularyzuje procesory 32 bitowe dzięki wprowadzeniu na rynek i386. Procesor ten wykorzystywany był w wielu popularnych w tym czasie modelach komputerów, takich jak np. Deskpro 386.

Apple próbuje stworzyć przenośny komputer w 1989 roku. Powstaje wtedy Macintosha Portable, który był ciężki i sprzedawał się słabo. Firma szybko wycofuje się z jego produkcji.

Początek lat 90-tych i trumf Windowsa

Na początku lat 90-tych Intel tworzy superkomputer Touchstone Delta. Korzystał on z 512 połączonych ze sobą procesorów i oferował olbrzymią jak na tamte czasy moc obliczeniową. Architektura w oparciu o jaką był zbudowany, okazała się być sukcesem i została wykorzystana w wielu późniejszych superkomputerach.

W 1991 roku Apple powraca z próbą stworzenia laptopu. Powstaje wtedy PowerBook, który zdobywa popularność wśród użytkowników.

Intel tworzy w tym czasie superkomputer Paragon, który korzystał z mocy obliczeniowej ponad 2 tysięcy połączonych ze sobą procesorów. Wykorzystywany był w badaniach nad atmosferą oraz energią.

W 1993 roku powstaje procesor Pentium od Intela. Był on w stanie obsługiwać grafikę oraz muzykę. Doprowadził do dużych zmian w domowych komputerach. Od teraz nie tylko posiadały one większą moc obliczeniową, ale także mogły wyświetlać zaawansowaną grafikę. Oto reklama procesora Pentium:

1995 rok, to czas kiedy pojawia się Microsoft Windows 95. Największym osiągnięciem produktu Billa Gatesa był interface użytkownika, który bez większych zmian wykorzystywany jest po dziś dzień. Przykładem popularności designu może być np. menu start. Podczas pierwszego roku Windows 95 sprzedał się w 40 milionach egzemplarzy.

Podsumowanie

Jeżeli wydawałoby się, że badanie historii IT jest łatwiejsze niż badanie, powiedzmy XIX wieku, to są to zaledwie pozory. Możemy być pewni, że wiele istotnych dokumentów związanych z przeszłością informatyki leży gdzieś zapomniana w jakiś archiwach, albo nadal jest utajniona. Do tego dochodzą problemy związane z trudnościami w uruchomieniu starych urządzeń i przeczytaniu dokumentów znajdujących się na archaicznych już formach zapisu.

Artykuł powstał dzięki:

CONNECTIS_

+48 22 222 5000

office.pl@connectis.pl

Złota 59

00-120 Warszawa

CONNECTIS_ jest spółką technologiczną świadczącą usługi z zakresu outsourcingu specjalistów, zespołów projektowych oraz procesów IT.

CONNECTIS_ łączy wyjątkowe doświadczenie, kompleksową znajomość branży oraz kompetencje specjalistów z klientami, aby pomóc im usprawniać projekty informatyczne i zwiększać wydajność procesów biznesowych.

Współpracujemy na szeroką skalę z liderami branżowymi w całej Europie z sektora m.in. finansowego, IT, konsultingowego, ubezpieczeniowego, energetycznego oraz telekomunikacyjnego. Codziennie wspieramy ich ponad 350 specjalistami w strategicznych projektach informatycznych.

Coders Lab

Łącząc doświadczenie edukacyjne ze znajomością rynku pracy IT, Coders Lab umożliwia szybkie i efektywne zdobycie pożądanych kompetencji związanych z nowymi technologiami. Skupia się się na przekazywaniu praktycznych umiejętności, które w pierwszej kolejności są przydatne u pracodawców.

Wszystkie kursy odbywają się na bazie autorskich materiałów, takich samych niezależnie od miejsca kursu. Dzięki dbałości o jakość kursów oraz uczestnictwie w programie Career Lab, 82% z absolwentów znajduje zatrudnienie w nowym zawodzie w ciągu 3 miesięcy od zakończenia kursu.

Zostaw komentarz