AI – Artificial intelligence

Pragnienie, by stworzyć autonomicznego robota, który myślałby jak człowiek, nie jest bynajmniej czymś nowym. Marzenie to w różnych wariantach przyświecało ludzkości od zawsze. Początkowo wiązane było z mocami, jakie dzierżyli kapryśni bogowie. Wraz z rewolucją naukową XVII wieku i następującym po niej coraz to szybszym procesem odmagicznianiania świata, ludzkość uznała, że możliwość skonstruowania myślącej maszyny leży w zasięgu jej ręki.

Światem rządzą mechaniczne prawa, których zgłębienie pozwala ujarzmić rzeczywistość. Sprawczość, jaką w ten sposób otrzymał człowiek, wykorzystana została do bezprecedensowego polepszenia warunków bytowych np. poprzez zwiększenie wydajności plonów czy wyeliminowane wielu zabójczych wcześniej chorób.

W podobny sposób jak świat funkcjonuje ludzki umysł. Jakkolwiek skomplikowany by on nie był, rządzą nim mechaniczne prawa. Wszystkie zachodzące w mózgu procesy da się zreplikować oraz przetłumaczyć na język binarny.

Jeżeli stworzenie w pełni samoświadomego AI jest jak na razie jedynie pieśnią przyszłości, to ludzkość już od paru dobrych dekad korzysta z rudymentarnie funkcjonującej sztucznej inteligencji. Jak do tego doszło?

Starożytne pierwsze koncepcje

Samą koncepcję dzieł ludzkich rąk, które obdarzone są życiem oraz myślą, można odnaleźć już w starożytności. Owidiusz pisał w swoich poematach o Pigmalionie, młodym mężczyźnie, który wyrzeźbił z kości słoniowej statuę pięknej kobiety. Jej uroda tak mocno przyćmiewała wdzięki wszystkich innych kobiet, że jej twórca zapłonął do niej miłością. Afrodyta zlitowała się nad młodzieńcem i tchnęła życie w statuę. Pigmalion poślubił powstałą w ten sposób kobietę i miał z nią dziecko.

Przypadek Pigmaliona nie jest bynajmniej jedynym greckim mitem, w którym można doszukiwać się wczesnych wersji idei, które przyświecać będą w przyszłości entuzjastom robotyki oraz twórcom sztucznej inteligencji.

Talos na greckiej monecie- autor nieznany

Hefajstos, bóg kowalstwa, metalurgii i rzemiosła, miał według podań wielokrotnie tworzyć automatyczne roboty. Jednym z nich były złote stoły, które posłuszne głosom olimpijskich bogów, zastawione najlepszym jedzeniem przychodziły na każde ich wezwanie. Jeszcze innym był Talos, olbrzym z brązu, którego zadaniem była ochrona Europy, córki króla Minosa przed piratami. Hefajstos wytapiał też posągi lwów oraz byków, które umiały mówić i pełniły funkcje strażnicze.

Ważne w tych mitach jest to, że koncepcje w nich zawarte nie różnią się tak mocno od współczesnych wyobrażeń na temat AI. Marzenie Pigmaliona o posiadaniu robota jako towarzysza jest bliźniaczo podobne do pragnień głównego bohatera filmu Her z 2013 roku. Maszyny, które wytapiał w swych hutach Hefajstos, pełniły funkcje czysto użytkowe, a zadania jakimi je obarczono zasadniczo nie były różne od współczesnych pomysłów na to, jak w niedalekiej przyszłości funkcjonować mają roboty wojskowe.

W średniowieczu idea stworzenia sztucznego bytu, który obdarzony byłby możliwością myślenia, nie zginęła. Alchemicy próbowali wytworzyć w swoich laboratoriach homunkulusa, a żydowska koncepcja ulepienia z gliny sługi golema, stała się w naszych czasach popularnym motywem fantastyki.

Epoka Nowożytna

W XVII wieku francuski filozof Kartezjusz postulował, że ciała zwierząt nie są w sposób zasadniczy różne od maszyn. Każda akcja powodowała reakcję, a świat działał według prostych mechanicznych zasad:

„O ile by istniały takie maszyny, które miałyby narządy i zewnętrzną postać małpy lub jakiegoś innego bezrozumnego zwierzęcia, nie posiadalibyśmy żadnego środka do rozpoznania, że nie są one we wszystkim tej samej natury” [i]

Niedługo po Kartezjuszu, niemiecki filozof Leibniz uważał, że możliwe jest stworzenie języka filozofów i matematyków. Każdą ideę, obojętnie jak skomplikowana by on nie była, można sprowadzić do serii prostych konceptów. Język taki byłby absolutnie dokładny, wszystkie problemy wynikające z różnego rozumienia tych samych słów przez dyskutantów zostałyby wyeliminowane. Błędy w rozumowaniu widoczne byłyby gołym okiem, a wyeliminowanie ich byłoby łatwizną. Żadna eretryjska, obojętnie jak zręczna by ona nie była, nie mogłaby zakryć prawdy.

Jeżeli pomysł stworzenia perfekcyjnego języka podobnego do matematyki zaproponowany przez Leibniza okazał się być z góry skazany na porażkę, to jednak koncepcja filozofa zapowiadała przyjście zupełnie innego rodzaju języka. Języka służącego do programowania.

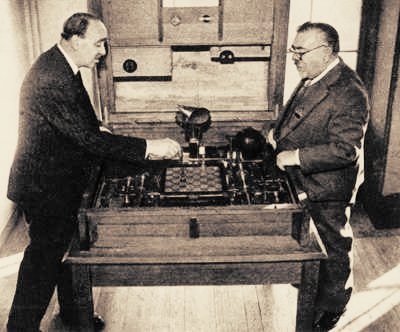

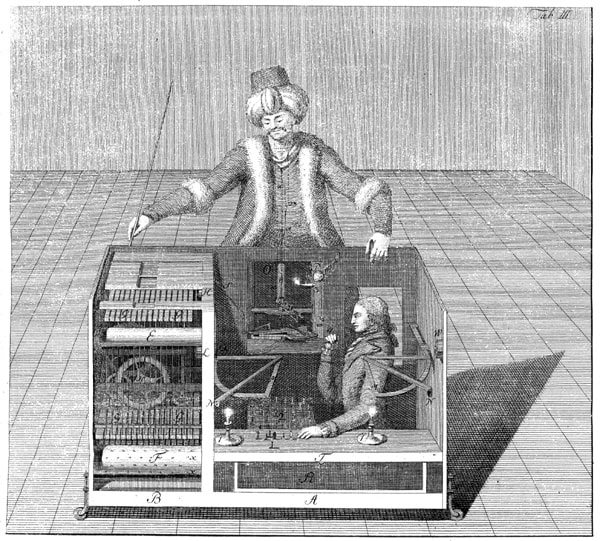

Na przełomie XVIII i XIX wieku olbrzymią popularność zdobył Turek. Była to lalka wielkości mniej więcej dorosłego człowieka przytwierdzona do szachownicy. Miała ona być w pełni automatyczna oraz grać w szachy lepiej niż większość ludzi. Turek wędrował po Europie przez dekady, odwiedzając królewskie oraz szlacheckie salony. Grał nawet z Napoleonem, który podobno czerpał dużą satysfakcję z prób trollowania maszyny poprzez wykonywane posunięć sprzecznych z zasadami szachowymi.

Jak się oczywiście potem okazało, Turek był oszustwem, a wszystkie posunięcia wykonywane były przez karła znajdującego się w środku i manipularnego rękoma kukły za pomocą sznurków. Wielu ludzi wierzyło jednak autentyczność maszyny.

Początki XX wieku

1914 maszyna szachowa- autor nieznany

W 1914 roku hiszpański inżynier Leonardo Torres y Quevedo zaprojektował maszynę, która samodzielnie umiała rozgrywać końcówki szachowe. Dokładnie siedem lat później czeski pisarz Karel Čapek pisze swoją powieść fantastyczno-naukową zatytułowaną Roboty Uniwersalne Rossuma. To jej świat zawdzięcza określenie „robot” wywodzące się z czeskiego słowa oznaczającego „pracować”.

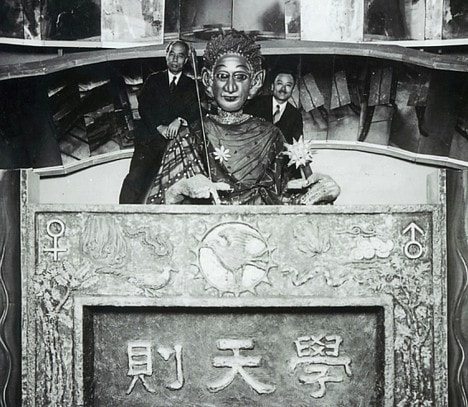

Gakutensoku – Osaka Mainichi-shinbun

W 1927 roku sławny reżyser Fritz Lang w swoim arcydziele niemieckiego ekspresjonizmu – Metropolis, po raz pierwszy wprowadził na ekrany kin postać robota. Dwa lata później w Japonii skonstruowany zostaje pionierski robot noszący nazwę Gakutensoku. Potrafił on automatycznie zmieniać wyraz swojej twarzy oraz poruszać rękoma.

W 1942 roku słynny pisarz science fiction Isaac Asimov w swoim opowiadaniu „Ja, robot” przedstawił 3 prawa, według którymi powinny się kierować maszyny podczas interakcji z człowiekiem:

1. Robot nie może skrzywdzić człowieka ani przez zaniechanie pozwolić, aby człowiek doznał krzywdy.2. Robot musi być posłuszny rozkazom człowieka, chyba że stoją one w sprzeczności z Prawem Pierwszym.

3. Robot musi chronić samego siebie, o ile tylko nie stoi to w sprzeczności z Pierwszym lub Drugim Prawem.

Parę lat później dodał on prawo zerowe zakazujące bezpośredniego oraz pośredniego krzywdzenia ludzkości jako takiej. Koncepcja Asimova okazała się niezwykle popularna i była powielana w licznych późniejszych dziełach kultury.

W 1950 jeden z pionierów opracowujących sztuczną inteligencję Alan Turing, opracował test mający sprawdzić, czy AI osiągnęło już dostateczny poziom, żeby można było powiedzieć, że naprawdę myśli. Ciężko jest znaleźć obiektywne wyznaczniki inteligencji ani zdefiniować co słowo „myśleć” oznacza tak naprawdę. Wraz z postępami nauki, granice tego co trzeba było umieć, aby posiadać ludzką inteligencję, były wielokrotne redefiniowane. Warto tutaj zwrócić uwagę na umiejętność posługiwania się narzędziami przez zwierzęta. Przez wieki myślano, że tylko człowiek posiadł tę zdolność, aż badania zoologów zaprzeczyły temu wyobrażeniu.

Turing zaproponował test, który nie wymagałby żadnych obiektywnych kryteriów definiujących co to znaczy posiadać zdolność myślenia. Zamiast tego kilkoro anonimowych osób, wśród których znajduje się ukryty komputer, ma prowadzić między sobą rozmowę za pośrednictwem czatu. Jeżeli AI nie potrafi myśleć, to partycypanci powinni z łatwością odgadnąć, który z nich nie jest człowiekiem. Myślące AI, z kolei, powinno odnieść sukces w przekonaniu wszystkich uczestników dyskusji, że jest ono istotą ludzką.

Test Turinga stał się bardzo znany i wpływowy wśród osób zajmujących się sztuczną inteligencją. Nawet wielu laików o nim słyszało. Jest on często krytykowany przez współczesnych specjalistów, ponieważ uważają oni, że zdolność symulacji ludzkich konwersacji nie jest dostatecznym wyznacznikiem myślenia. Można napisać program, który byłby świetnym dyskutantem, lepszym nawet niż większość ludzi, ale nie rozumiałby on treści tego, co mówi. Ciężko jest określić taki program jako rzeczywiście inteligentny.

Złote Czasy AI

W 1955 roku Allen Newel, Herbert Simon oraz Cliff Shaw napisali program Logic Theorist. Program ten rozwiązywał matematyczne problemy, myśląc podobnie jak człowiek, czasem w bardziej elegancki sposób niż przewidzieli to ich twórcy. Autorom Logic Theorist udało się wykazać, że pomysł stworzenia sztucznej inteligencji posiada mocne podstawy i że warto jest podjąć wysiłki ku temu celowi zmierzające. Logical Theorist uznawany jest za pierwszy AI napisany przez człowieka.

.”]„Podczas świąt Al Newel oraz ja wynaleźliśmy myślącą maszynę” Herbert Simon do swoich studentów w styczniu 1956 roku[ii].

Konferencja w Dartmouth odbyła się w 1956 roku i uczestniczyli w niej wiodący w tamtym okresie naukowcy zajmujący się kwestią sztucznej inteligencji. Wiedziano już wtedy, że mózg ludzki funkcjonuje w sposób podobny do komputera. Sieć neuronowa, z której się składa ten służący do myślenia narząd, funkcjonuje poprzez wysyłanie sygnałów elektrycznych. Doszukiwano się tutaj podobieństw do kodu binarnego. Uważano więc wtedy, że stworzenie elektronicznego mózgu, który perfekcyjnie symulowałby oryginał, jest tylko kwestią czasu. John McCarthy ukuł podczas konferencji pojęcie „sztucznej inteligencji” i wraz z resztą jej uczestników sformował cele, których osiągniecie miało doprowadzić, do szybkiego spełnienia postawionych przez nich postulatów.

Konferencja w Datmouth okazała się być dużym sukcesem, za którym poszły przyznawane przez Departament Obrony granty na badania. Rząd liczył, że postępy w sztucznej inteligencji pozwolą na powstanie idealnego tłumacza, który bezbłędnie będzie przekładał treść z jednego języka na drugi. Zdobywszy potrzebne fundusze, naukowcy gotowi byli do dalszej pracy nad AI.

W tym okresie dokonano wielu przełomów. Stworzono program, który rozwiązywał niektóre problemy z testów IQ (Analogy, 1963) czy Dendral (1967), który jako pierwszy potrafił formułować hipotezy, a potem sprawdzać ich prawdziwość. Program ten zaczęto wykorzystywać w prowadzeniu badań chemicznych. W 1970 roku powstaje w Japonii pierwszy antropomorficzny robot- Wabot-1. Umiał on poruszać się, przenosić przedmioty oraz wykorzystywać prostą komunikację głosową.

Na początku lat 70-tych wydane zostały raporty krytykujące sensowność dalszego finansowania projektów tworzenia sztucznej inteligencji, co doprowadziło do zakręcenia kurka z pieniędzmi. Stworzenie funkcjonalnego AI było niemożliwe, ponieważ, zdaniem autorów raportów, moc obliczeniowa komputerów była w tym czasie zbyt słaba. Brak odpowiednich baz informacji potrzebnych, aby komputer mógł w jakikolwiek sensowny sposób nauczyć się interpretować rzeczywistość, także była przedstawiana jako bariera niemożliwa do przeskoczenia w latach 70-tych. Tak oto nadeszła Zima AI.

Sztuczna Inteligencja, a gry strategiczne

Jednym z pytań, które pasjonowało pionierów sztucznej inteligencji, było to, czy możliwe jest, żeby komputerowy program okazał się bardziej inteligentnym od człowieka. To jaki sposób powinno się definiować inteligencję, stanowiło już wtedy duży problem, problem, którego po dziś dzień nie udało się w sposób satysfakcjonujący rozwiązać.

Jako że gry strategiczne mają jasne zasady ustalające kto wygrał, a kto przegrał, powszechnie mówi się, że wymagają myślenia, są dosyć skomplikowane oraz łatwo przełożyć ich reguły na język komputerowy, to zostały one wybrane do tego, aby przetestować możliwości AI.

Sztuczna inteligencja, żeby móc osiągnąć optymalne umiejętności w grze, musi zakładać, że przeciwnik zawsze wykona najlepszy z możliwych dostępnych dla niego posunięć. AI tworzy schemat drzewa, na którym rozpisuje ona wszystkie dostępne obu stronom możliwości i na tej podstawie określa, które z nich są najlepsze. Tego rodzaju schematy mogą być bardzo głębokie i przewidywać wszystkie możliwe stany, w jakich może znaleźć się gra na wiele ruchów do przodu.

Problem z tą metodą polega na tym, że liczba stanów gry, jakie trzeba przeliczyć gwałtownie rośnie z każdym kolejnym posunięciem. Dlatego też ważne jest, żeby znaleźć sposób, dzięki któremu AI będzie odrzucało bezsensowne posunięcia i liczyło tylko stany w jakich gra znajdzie się po wykonaniu rozsądnych ruchów. Jest to główne wyzwanie stojące przed każdym twórcą sztucznej inteligencji, która ma dobrze grać w gry strategiczne.

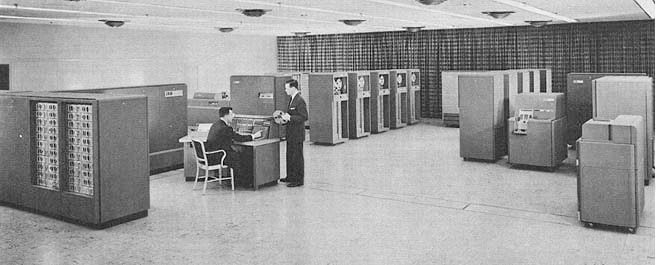

IBM 1955- RTC

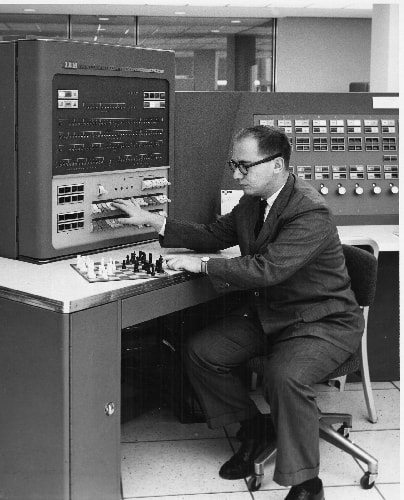

W 1952 roku Turing skonstruował pierwszą maszynę grającą w szachy (TurboChamp), ale była ona słaba i nie potrafiła dobrze dobierać posunięć. Pięć lat później Alex Bernstein stworzył na maszynie IBM 704 program komputerowy, który grał na poziomie przeciętnego amatora.

bernstein- z https://videogamehistorian.wordpress.com/tag/computer-game/

Jako że gra w szachy była trochę zbyt wymagająca dla ówczesnych komputerów, to postanowiono poświęcić więcej uwagi warcabom. W warcabach zazwyczaj istnieje mniej dostępnych posunięć niż w szachach, co bardzo usprawniało pracę.

warcaby Samulea z http://www-03.ibm.com/ibm/history/ibm100/us/en/icons/ibm700series/impacts/

W 1956 roku Arthur Samuel napisał pierwszy program umiejący grać w warcaby. Ulepszał go on przez parę lat. Wersja powstała w 1962 roku pokonała Robert Nealey, który był mocnym graczem. (link do zapisu gry: http://www.fierz.ch/samuel.htm) Program ten ulepszył nieco przedstawiony powyżej schemat drzewa poprzez wprowadzenie jednej bardzo ważnej umiejętności: uczenia się. Zapamiętywał on pozycje, które okazały się dla niego szczególnie korzystne i starał się do nich doprowadzić w przyszłych grach.

W 1994 roku Chinook, korzystając z obszernej bazy końcówek warcabowych, zremisował z ówczesnym mistrzem świata, Marionem Tinsley’em, 6 gier i pokonał drugiego najlepszego zawodnika, Dona Lafferty’ego, z wynikiem: 1 zwycięstwo oraz 31 remisów.

Wraz z rozwojem siły obliczeniowej komputerów, rosły możliwości tworzonych programów. Jako, że sztuczna inteligencja najczęściej preferowała siłowe rozwiązania podczas poszukiwań optymalnych posunięć, to dostępna moc obliczeniowa w sposób znaczący przekładało się poziom gry, jaki reprezentowały maszyny.

W 1974 roku odbyły się pierwsze mistrzostwa świata komputerów w grze w szachy. Spośród 13 uczestników najlepszy okazał się radziecki program Kaissa, który wygrał 4 partie. Sukces odniósł dzięki kilku innowacyjnym osiągnięciom jak np.: posiadaniu książeczki debiutowej, w której zawarte było 10 000 pierwszych posunięć jakie można wykonać podczas gry.

W 1997 roku Deep Blue pokonuje ówczesnego szachowego mistrza szachów Garri Kasparowa, wygrywając 3,5 do 2,5. To link do wszystkich gier w meczu: http://www.chessgames.com/perl/chess.pl?pid=29912&pid2=15940 .

Po porażce rosyjskiego czempiona jedyną grą strategiczną, którą komputer nie był w stanie pokonać, było Go. Go pochodzi z Chin i charakteryzuje się liczbą stanów gry, która w sposób znaczący przewyższa liczbę możliwych wariantów, jakie oferują szachy. Stanowiło to olbrzymią zaporę dla siłowo rozwiązujących wszystkie problemy programów, ale wraz ze wzrostem mocy procesorów oraz ciągłym znajdywaniem nowych sposobów na zmniejszenie liczby obliczeń potrzebnych do prawidłowej oceny sytuacji na planszy, problem ten został przezwyciężony.

W 2016 roku AlphaGo pokonuje wielokrotnego mistrza tej gry Lee Sedola wygrywając 4 z 5 partii.

„W naszych czasach praktycznie niemożliwe jest pokonanie maszyny”- Garry Kasparrow[iii].

Koniec pierwszej Zimy AI

W latach 80-tych po dekadzie braku funduszy na rozwój sztucznej inteligencji, wraca ona do łask rządzących. Stało się tak dzięki finansowaniu jakie rządy Japonii oraz Wielkiej Brytanii poświęciły na próby stworzenia programów eksperckich. Miały one wspomóc albo nawet zastąpić wysoko wykwalifikowanych specjalistów, którzy zajmowali się wąskimi dziedzinami.

Przykładem tego typu oprogramowania był opracowany w 1980 roku Xcon, który automatycznie wybierał komponenty zamawianego sprzętu na podstawie specyfikacji klienta. Program cechował się większą dokładnością i szybkością niż ludzcy pracownicy.

W połowie lat 80-tych program Aaron zaczyna samodzielnie tworzyć nieabstrakcyjne obrazy przedstawiające ludzi oraz obiekty takie jak skały czy drzewa. W latach 90-tych nauczy się on malować swoje dzieła w kolorze.

AI w tym okresie znalazło sobie kilka wyspecjalizowanych nisz, w których było wykorzystywane. Znajdowały się one zwykle z dala od oczu większości społeczeństwa.

Problemem, jaki trapił naukowców zajmujących się opracowywaniem sztucznej inteligencji, było obiecywanie zbyt dużych i zbyt szybkich postępów. Mimo tego, że badania nad AI szły do przodu, to z powodu wcześniejszych zbyt szumnych zapowiedzi, sukcesy zawsze wydawały się mniejsze niż były w rzeczywistości.

Lata 90 i początek XXI wieku.

Pomysł MITu na stworzenie robota, który tak samo, jak niemowlę uczyłby się interakcji społecznych, na podstawie swoich doświadczeń z ludźmi ożywił na nowo entuzjazm dla AI. Dzięki temu Cob, bo tak miał się nazywać robot, miałby samodzielnie nauczyć się imitować ludzkie zachowania.

W 1997 roku powstaje LSTM. Jest to się sieć neuronowa, która używana jest dzisiaj w programach rozpoznających mowę. W tym samym roku rozegrany zostanie pierwszy mecz piłki nożnej rozgrywany samodzielnie przez roboty.

W 1998 roku sztuczna inteligencja zawitała do domów ludzi posiadających potomstwo. Popularność zdobywa Furby, zabawka mająca przy użyciu AI zabawiać dzieci. Od tego czasu inteligentne zabawki zaczynają zdobywać popularność.

W 2000 roku MIT tworzy Kismet, maszynę, która potrafiła rozpoznać i naśladować mimikę ludzkich emocji. W tym samym roku Honda tworzy robota ASIMO, który jest w stanie poruszać się z taką samą szybkością jak człowiek.

W 2007 roku Uniwersytet Princeton buduje olbrzymią bazę obrazów, która w przyszłości ma być używana przez AI do rozpoznawania znajdujących się przed nimi obiektów.

Od 2009 roku Google pracuje nad samochodem, który będzie prowadził się sam. Technologia przewidywana jest wejść do użytku w ciągu kilku najbliższych lat.

Żyjemy w ciekawych czasach, czasach, które wydają się na bank wydać pierwsze rzeczywiście myślące AI. Jaki będzie to miało wpływ na społeczeństwo oraz gospodarkę? Czy ziszczą się wizje pochodzące z lat 50-tych ubiegłego wieku przedstawiające przyszłość, w której większą część prac przejęły roboty, a ludzkość oddaje się rozrywce, nauce i kontaktom towarzyskim?

A może mylimy się tak samo, jak ludzie żyjący w poprzednich dekadach myśląc, że inteligentne AI jest na wyciągnięcie naszych rąk? Mimo postępów w tej dziedzinie sztuczna inteligencja generalnie stała się tylko lepsza w rozwiązywaniu problemów metodą siłową, metodą wykonywania dużej liczby obliczeń i wybierania jednego z dostępnych rozwiązań. Czy naprawdę można określić to jako prawdziwą inteligencję? A jeżeli nie, to jaka jest granica pomiędzy jednym a drugim? Co sprawia, że myślenie, naprawdę jest myśleniem?

[i] https://www.google.pl/url?sa=t&rct=j&q=&esrc=s&source=web&cd=2&cad=rja&uact=8&ved=0ahUKEwjVvcy3yLDUAhUDMJoKHdYrCSsQFggyMAE&url=http%3A%2F%2Fwww.filo-sofija.pl%2Findex.php%2Fczasopismo%2Farticle%2Fdownload%2F298%2F295&usg=AFQjCNHY354w9op9rdcjCZnoOdH1LxCd-Q

[ii] http://shelf1.library.cmu.edu/IMLS/MindModels/problemsolving.html

[iii] http://www.hindustantimes.com/other-sports/virtually-impossible-to-beat-a-machine-in-this-age-deep-blue-conqueror-garry-kasparov/story-CJPsCvr0kbjzpNV4NRkhOP.html

Unified Factory

Unified Factory to system automatyzujący wielokanałową sprzedaż i obsługę klienta w kanałach voice (in/out), chat, e-mail i facebook messenger. Pioniersko w skali światowej wykorzystuje pamięć asocjacyjną wspartą autorskimi algorytmami rozumienia tekstu naturalnego, które umożliwiają nie tylko 80% przyśpieszenie obsługi, ale i stworzenie inteligentnych wyszukiwarek tekstowych, produktowych czy botów potrafiących precyzyjnie przygotować odpowiedź na podstawie całościowej treści z zapytania klienta.

Coders Lab

Łącząc doświadczenie edukacyjne ze znajomością rynku pracy IT, Coders Lab umożliwia szybkie i efektywne zdobycie pożądanych kompetencji związanych z nowymi technologiami. Skupia się się na przekazywaniu praktycznych umiejętności, które w pierwszej kolejności są przydatne u pracodawców.

Wszystkie kursy odbywają się na bazie autorskich materiałów, takich samych niezależnie od miejsca kursu. Dzięki dbałości o jakość kursów oraz uczestnictwie w programie Career Lab, 82% z absolwentów znajduje zatrudnienie w nowym zawodzie w ciągu 3 miesięcy od zakończenia kursu.

CONNECTIS_

+48 22 222 5000

office.pl@connectis.pl

Złota 59

00-120 Warszawa

CONNECTIS_ jest spółką technologiczną świadczącą usługi z zakresu outsourcingu specjalistów, zespołów projektowych oraz procesów IT.

CONNECTIS_ łączy wyjątkowe doświadczenie, kompleksową znajomość branży oraz kompetencje specjalistów z klientami, aby pomóc im usprawniać projekty informatyczne i zwiększać wydajność procesów biznesowych.

Współpracujemy na szeroką skalę z liderami branżowymi w całej Europie z sektora m.in. finansowego, IT, konsultingowego, ubezpieczeniowego, energetycznego oraz telekomunikacyjnego. Codziennie wspieramy ich ponad 350 specjalistami w strategicznych projektach informatycznych.

Zostaw komentarz